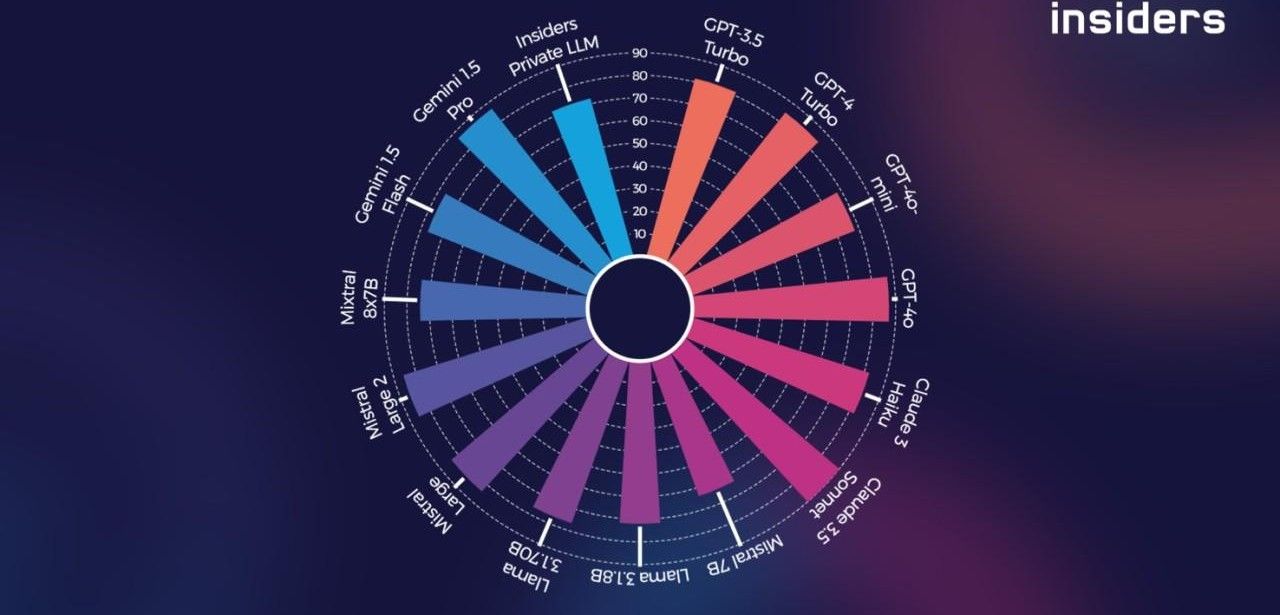

Mit dem innovativen Tool von Insiders Technologies haben Versicherungsunternehmen die Möglichkeit, Large Language Modelle (LLMs) als KI-Komponenten für ihr Inputmanagement gezielt auszuwählen. Hierbei werden spezifische Anforderungen berücksichtigt, die im LLM Benchmarking vorgestellt wurden. Insgesamt wurden 15 Modelle getestet, darunter bekannte Versionen von OpenAI, Anthropic, Mistral, Meta und Google. Das Insiders Private LLM sticht dabei durch seinen hohen Datenschutzlevel hervor und bietet somit eine sichere Lösung zur Verarbeitung sensibler Informationen in der Versicherungswirtschaft.

Inhaltsverzeichnis: Das erwartet Sie in diesem Artikel

Insiders LLM Benchmarking: US-Anbieter führend dank Rechenleistung und Daten

Basierend auf dem aktuellen Insiders LLM Benchmarking haben US-amerikanische Anbieter aufgrund ihrer herausragenden Rechenleistung und umfangreichen Trainingsdaten die Spitzenpositionen eingenommen. Claude 3.5 Sonnet von Anthropic erreichte mit einem Score von 90,10 den ersten Platz im Gesamtranking, gefolgt von GPT-4o von OpenAI mit 87,11 Punkten. Den dritten Platz belegt Gemini 1.5 Pro von Google mit 86,98 Punkten. Das Insiders Private LLM erzielte eine bemerkenswerte Gesamtperformance von 72,33 und zeichnet sich durch seine hohen Datenschutzstandards aus. Es bietet somit eine ideale Lösung für die sichere und effiziente Verarbeitung sensibler Informationen in der Versicherungswirtschaft.

Branchenspezifische Aussagekraft durch umfangreiche Testdaten bei LLM Benchmarks

Insiders Technologies verfügt über mehr als 25 Jahre Erfahrung in der Versicherungswirtschaft und hat auf dieser Grundlage ein breites Testfeld entwickelt. Dieses Testfeld umfasst typische Anwendungsfälle wie Adressänderungen, Schadensberichte, SEPA-Mandate und medizinische Dokumente, um eine hohe branchenspezifische Aussagekraft des LLM Benchmarks zu gewährleisten. Rolf Zielke, Executive Consultant bei Insiders Technologies, betont die Transparenz, die der LLM Benchmark bietet, um gut informierte Entscheidungen bei der Auswahl von LLMs treffen zu können.

Konkrete Empfehlungen: Einsatz von LLMs basierend auf Benchmarks und Erfahrung

Mit der Insiders OvAItion Engine haben Versicherungsunternehmen Zugriff auf die aktuell besten Large Language Models (LLMs), die auch in Kombination genutzt werden können, um spezifische Anwendungsfälle abzudecken. Basierend auf umfangreichen Benchmarks und Erfahrungen aus Kundenprojekten in der Versicherungswirtschaft gibt Insiders konkrete Empfehlungen für den Einsatz bestimmter LLMs in spezifischen Use Cases. Die technische, vertragliche und datenschutzrechtliche Integration verschiedener KI-Modelle wurde bereits umgesetzt, sodass Kunden nahtlos zwischen verschiedenen KI-Technologien wechseln können, ohne Unterbrechungen oder Anpassungen vornehmen zu müssen. Dies ermöglicht den Einsatz von Best-of-Breed-Technologien ohne die üblichen Nachteile.

Individuelle Unterstützung bei Leistung, Sicherheit und Kosten in Versicherungen

Mit individuellen Benchmarkings und einer umfassenden Beratung unterstützt Insiders Technologies Versicherungsunternehmen dabei, ihre spezifischen Anforderungen in Bezug auf Leistung, Sicherheit, Kosten und Geschwindigkeit zu erfüllen. Durch die Nutzung modernster Deep-Learning-Verfahren und LLMs können Versicherungsunternehmen ihre Automatisierungsprozesse optimieren und den gewünschten Erfolg erzielen.

Flexibel und individuell: Die besten LLMs für Versicherungsunternehmen auswählen

Das regelmäßige LLM Benchmarking von Insiders Technologies ist von großer Bedeutung für die Versicherungswirtschaft, da es eine solide Entscheidungsgrundlage für den Einsatz von Large Language Modellen (LLMs) liefert. Durch ein umfangreiches Testfeld, die Flexibilität der OvAItion Engine und eine individuelle Beratung können Versicherungsunternehmen die besten LLMs für ihre spezifischen Anforderungen identifizieren. Das Insiders Private LLM zeichnet sich zudem durch hohe Datenschutzstandards aus, was besonders in der sensiblen Versicherungsbranche von großer Bedeutung ist.